H2Former

H2Former

论文:《H2Former: An Efficient Hierarchical Hybrid Transformer for Medical Image Segmentation》(TMI 2023)

文章贡献:

- 提出了一个分层混合模型,整合了CNN的局部信息、多尺度通道注意力特征和Transformer的长距离特征在一个统一的块内。

- 一个轻量级的多尺度通道注意力(MSCA)

- 在三个2D和两个3D医学图像分割任务上证明了模型的有效性

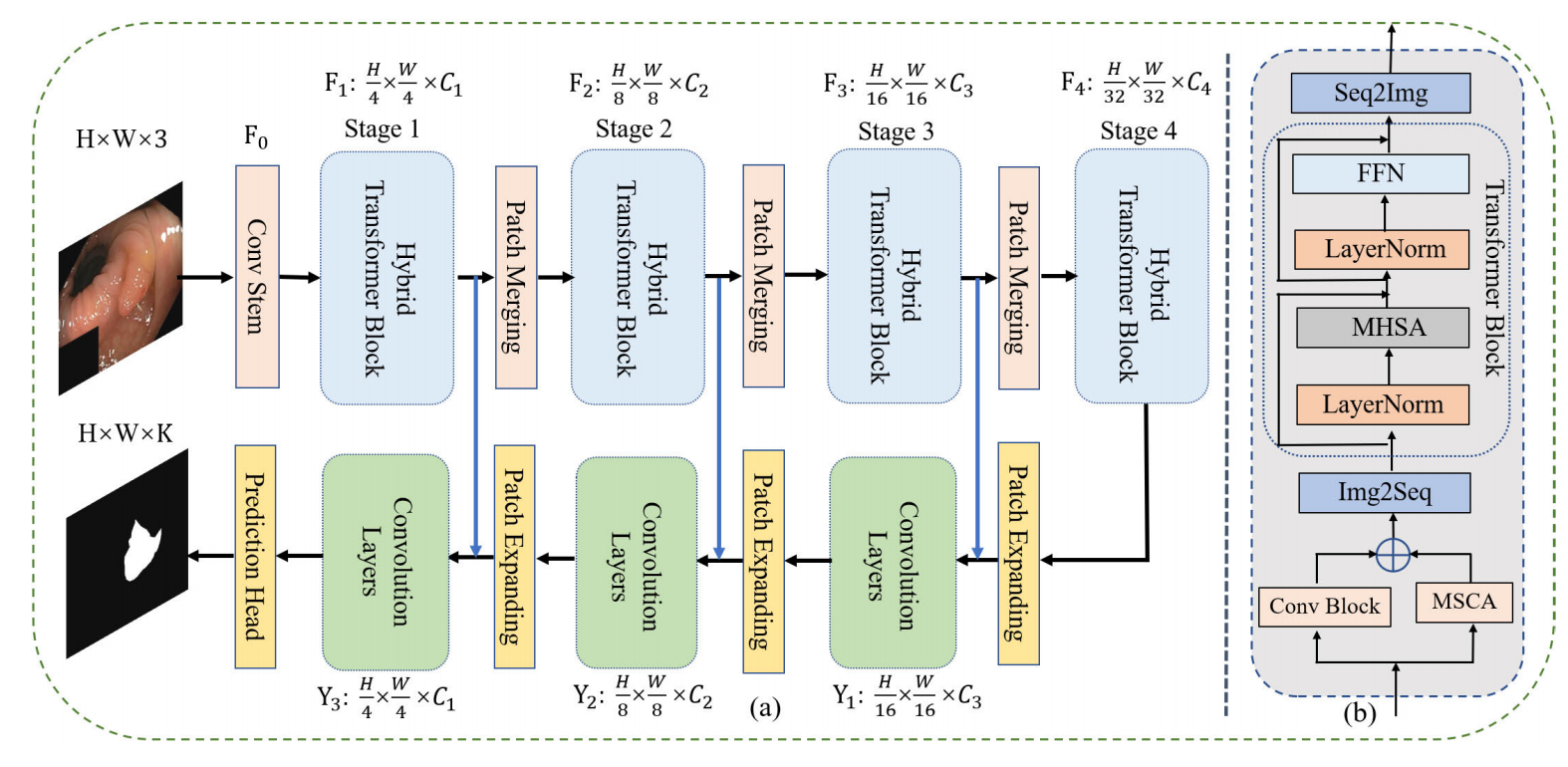

网络结构:

Conv stem:由一个卷积层和一个最大池化层,将输入的图像划分成多个patch,并对每个小块进行特征提取。

Hybrid Transformer Block:在特征提取过程中引入多尺度通道注意力、卷积层和Transformer层,以解决卷积的局部性和Transformer单一尺度特征的局限性。

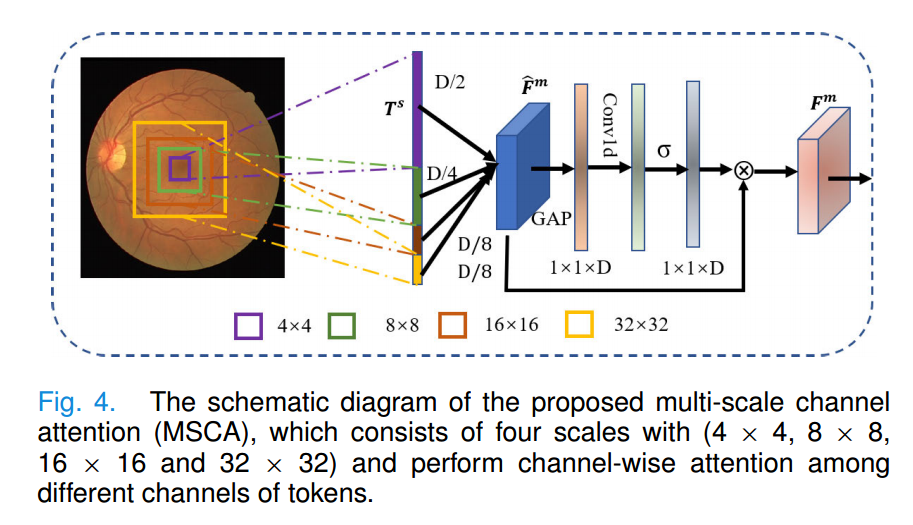

Multi-Scale Channel Attention (MSCA):捕捉不同形状和尺度的多尺度特征,并通过通道注意力机制对这些特征进行校准,从而去增强模型的表达能力

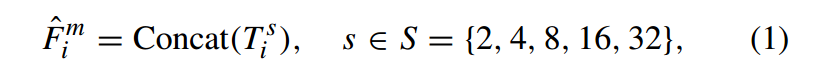

对于每个特征图,MSCA将其划分为多个尺度的token,并将这些token连接起来形成多尺度token(该过程通过使用具有不同大小的卷积核,步长为1的卷积操作来实现)

具体操作如下:

注:MST是multi-scale tokenization layers,其是使用s×s的核,步长为1的卷积实现的*

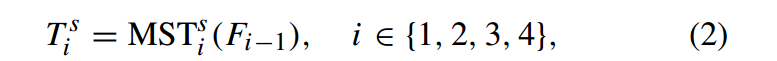

之后再使用多尺度通道注意力对提取的特征进行校准:

注:GAP(全局平均池化)、σ(Sigmoid激活)、Conv1d(kernel为3的一维卷积层)

为了降低MSCA的计算复杂度,大尺度时采用低维,小尺度时采用高维。对于第1阶段的高分辨率特征图,采用4 × 4、8 × 8、16 × 16和32 × 32四种尺度,输出维度分别为C/2、C/4、C/8和C/8。其余阶段,使用2 × 2和4 × 4两种尺度,输出维度分别为C/2、C/4。通过这样的方式,MSCA可以在合理的计算复杂度下提取多尺度特征。

Conv Block:采用卷积块提取局部空间特征

Transformer Block:为了使Transfomer块能够感知多尺度通道特征和局部空间特征,将多尺度通道特征和局部空间特征集成为Transfomer块的输入。

注:MHSA是基于窗口的多头自注意

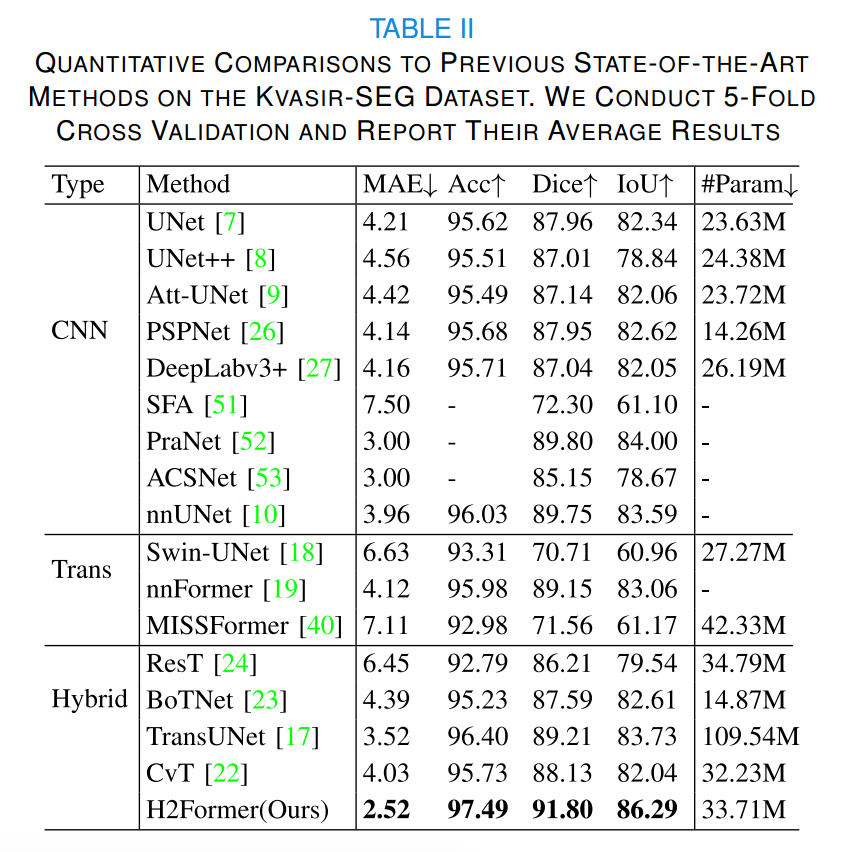

实验部分:

注1:H2Former相较于纯Transformer方法、纯CNN方法具有比较明显的优势

注2:表一为皮肤病变分割任务,表二是息肉病灶分割任务

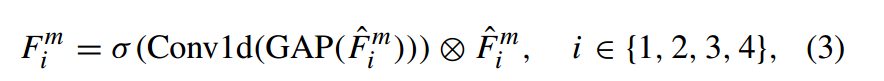

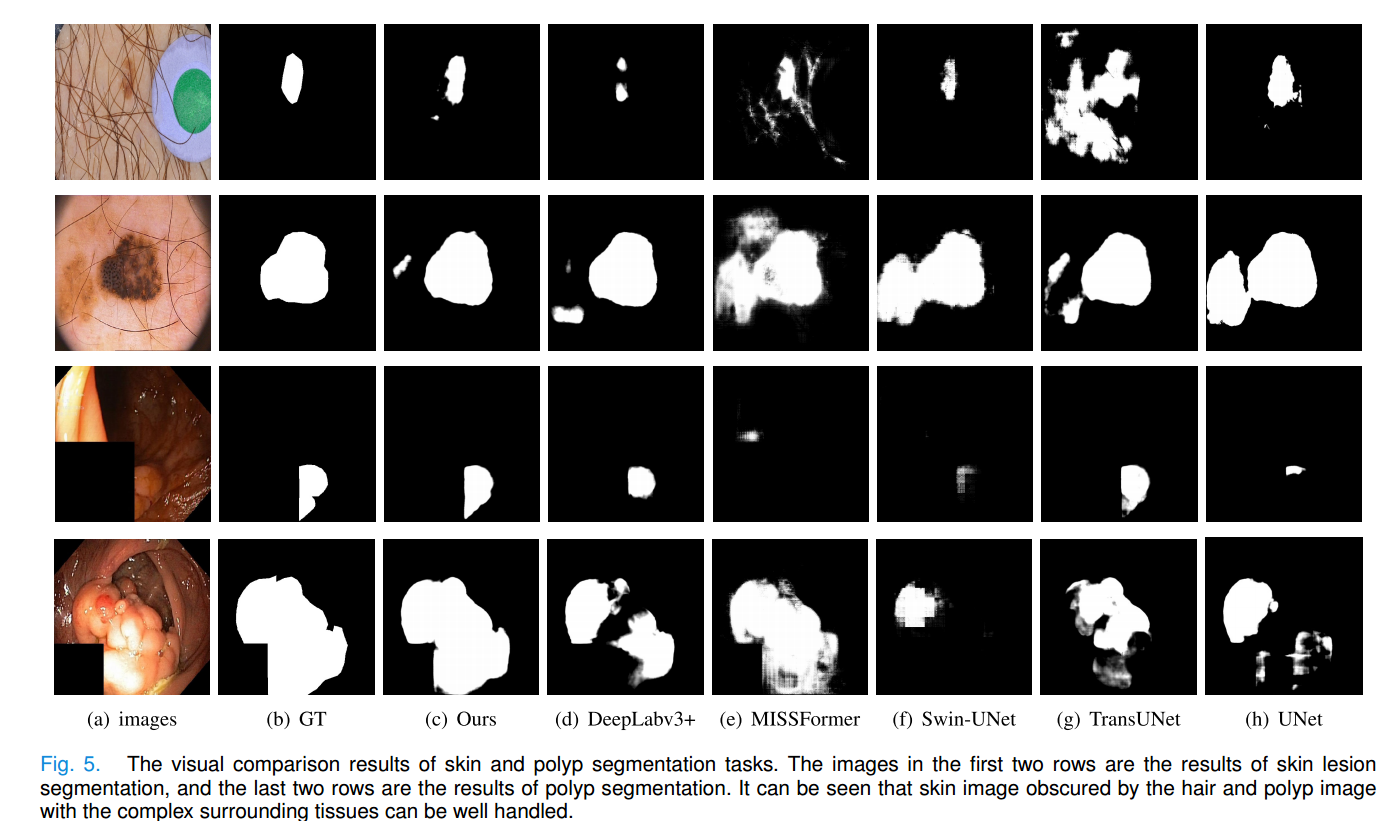

分割结果的可视化的对比:

注:前两行是皮肤病变分割的结果,后两行是息肉分割的结果。

通过对比发现:第一排的皮肤图像被毛发遮挡,第三排的息肉图像也被遮挡,但该模型仍可以产生清晰的边界,而其他模型的分割性能会因遮挡而下降