RotCAtt-TransUNet++:Novel Deep Neural Network for Sophisticated Cardiac Segmentation

RotCAtt-TransUNet++: Novel Deep Neural Network for Sophisticated Cardiac Segmentation

论文:《RotCAtt-TransUNet++: Novel Deep Neural Network for Sophisticated Cardiac Segmentation》(arXiv 2024)

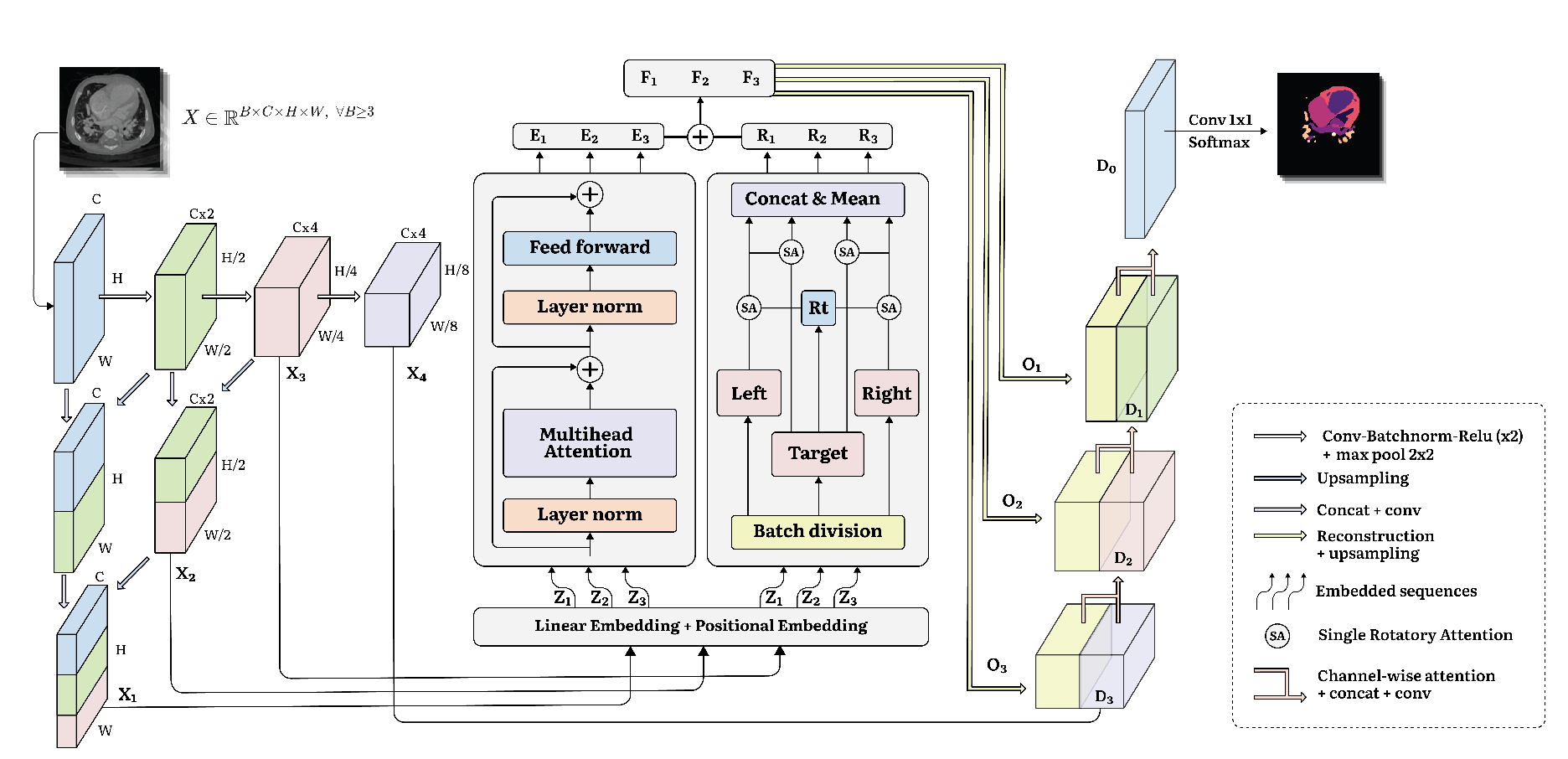

提出了一种新颖的旋转注意力机制(Rotatory Attention),用于捕捉体数据中相邻切片的信息。

编码器部分引入了UNet++的嵌套跳跃连接和密集的多尺度下采样,确保了在不同尺度上保留关键特征

- 设计了一个通道交叉注意力机制,通过引导Transformer特征的通道和信息过滤,解决了编码器与解码器特征间语义模糊的问题。

Transformer层有助于捕获片内交互,而旋转注意机制处理片间连接。

在跳跃连接处对不同深度和不同分辨率的特征图进行了融合

对前三个特征映射X1、X2、X3以不同的patch大小进行线性嵌入(),然后,通过transformer块捕捉patch之间的交互,并通过旋转注意力机制聚合相邻切片的信息

Linear Embedding 与 Positional Embedding

对于不同分辨率的特征图采用不同大小的patch(这样做可以保持特征图的代表性,不同分辨率的特征图包含不同尺度的信息),较小的patch有助于提取图像的局部细节特征,而较大的patch则有助于提取全局或上下文特征,然后对使用卷积操作映射到一个统一的维度。

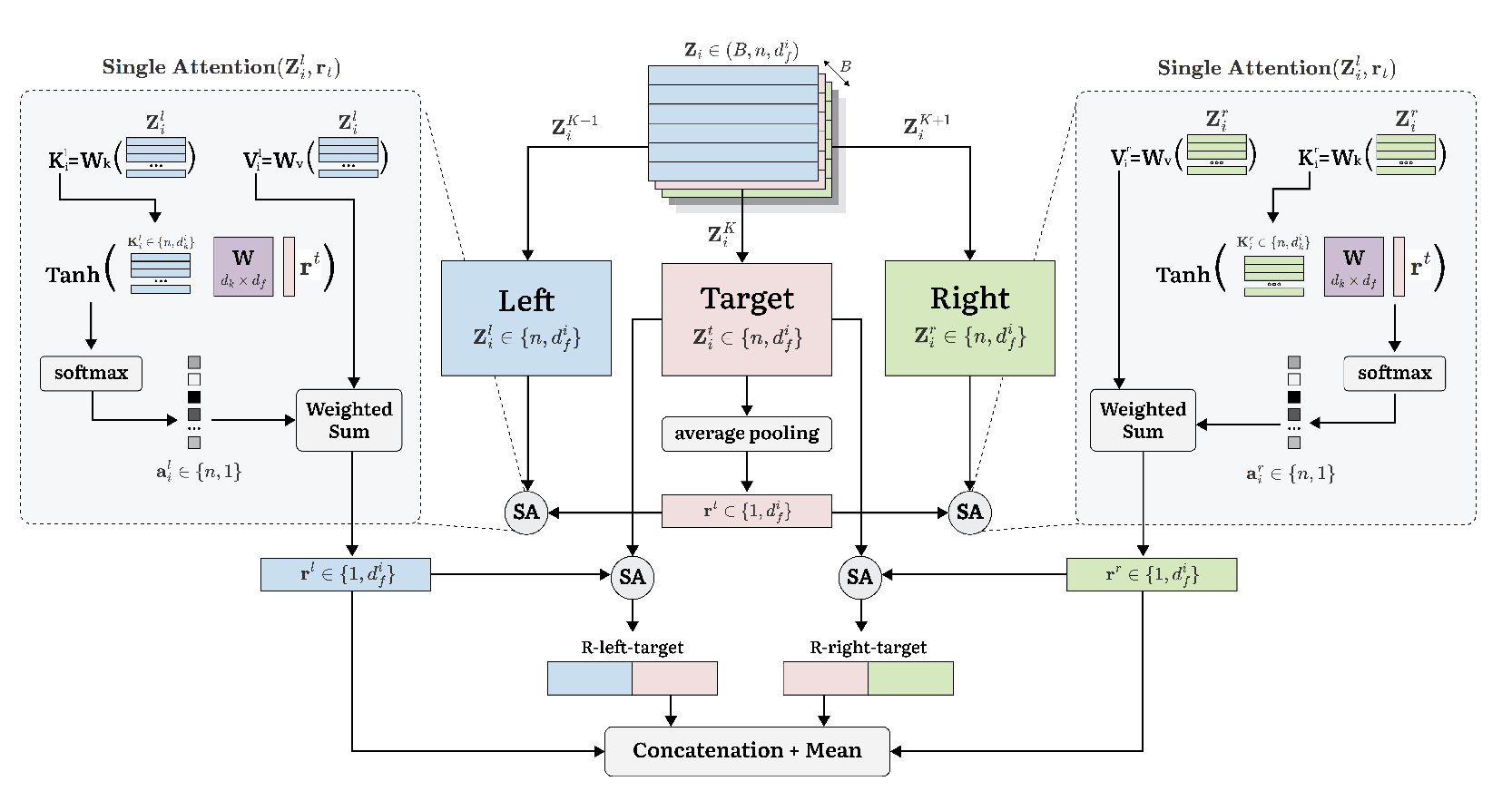

Rotatory Attention Block

作者使用旋转注意力机制来提取切片间的特征

该机制来源于自然语言处理中的左-中-右分离神经网络,用于捕捉句子中相邻单词之间的上下文关系。(相邻的元素对理解的中心有重要贡献)

输入:旋转注意力机制将批量大小视为多个连续切片的集合,并选择性地处理三个连续的切片—左切片(前一个切片)、目标切片(当前切片)和右切片(下一个切片)。

Left:

- 对左切片使用和来得到和

- 使用对目标切片的平均池化的结果作为查询,通过与和进行注意力的计算,得到左上下文融合后的特征

Right:同Left

目标上下文交互:通过单注意力(SA),将左上下文和右上下文整合到目标切片之中

最后,通过通道维度拼接和取平均的操作,得到最后的输出特征。

Channel-wise Attention Gate for Feature Fusion

对输入特征图进行全局平均池化,生成一个描述各通道重要性的向量,通过线性层对该向量进行变换,生成一个注意力掩码。

将生成的注意力掩码与解码器的特征图进行逐元素相乘,从而得到加权后的特征图。

- 加权后的特征图与解码器的原始特征图进行连接,以增强解码过程中的信息流动,进一步提升分割精度。