RNN

1.RNN(递归神经网络)

RNN:用于处理序列数据和时间序列数据。RNN具有循环连接,允许信息在网络内部传递。

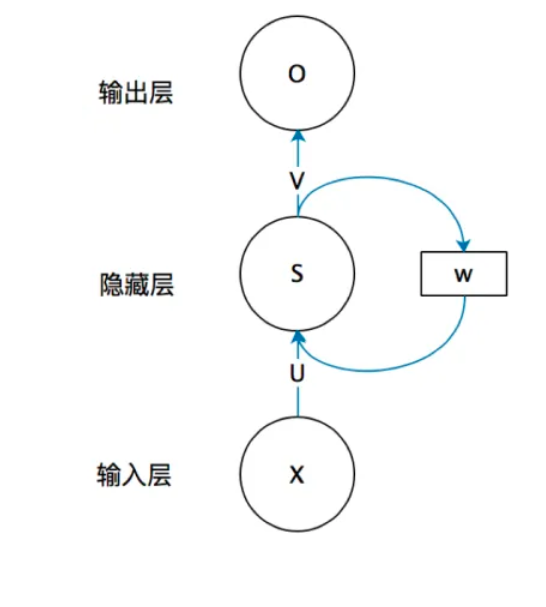

1.1 RNN的结构:

注:权重矩阵 W就是隐藏层上一次的值作为这一次的输入的权重

1.2 RNN的优劣

RNN的主要优点包括:

1.处理序列数据:RNN能够有效地处理变长序列数据,因为它的隐藏状态可以捕获先前时间步的信息。

2.上下文理解:RNN能够理解上下文信息。

RNN的缺点:

1.长期依赖问题:由于梯度消失或梯度爆炸的问题,传统的RNN在处理长序列时可能会失去对远距离时间步的依赖性。

2.计算效率:RNN的计算效率较低,难以处理大规模数据和长序列。

2.LSTM(长短期记忆)

LSTM:为了解决RNN在长序列训练过程中的梯度消失和梯度爆炸问题。

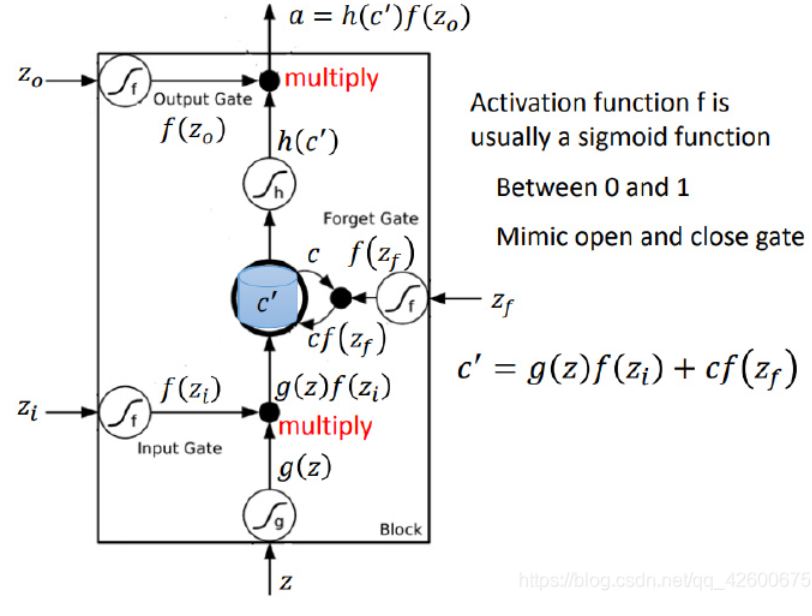

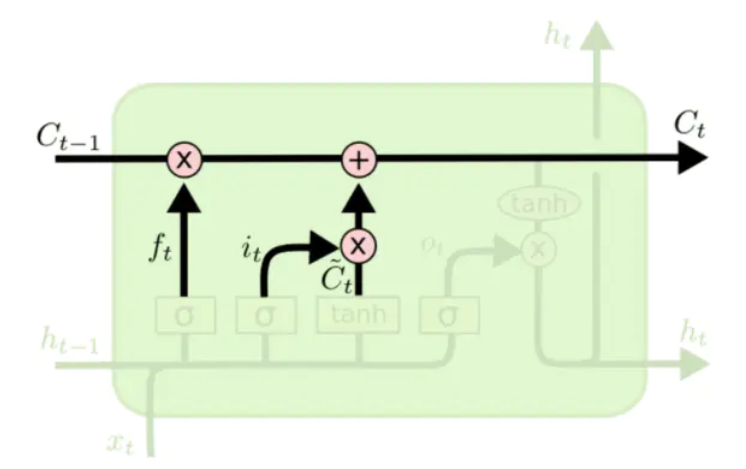

2.1 LSTM的结构原理:

输入:Z、输入门$Z_i$、输出门 $Z_o$、遗忘门 $Z_f$

输出:a

输入门$Z_i$:决定了哪些新信息要被存储到细胞状态中。它也考虑前一个时间步的隐藏状态和当前时间步的输入,以及一个候选值,用于更新细胞状态。

遗忘门 $Z_f$:决定了哪些信息要被遗忘或丢弃。输出一个介于0和1之间的值,表示要保留多少以前的信息。

输出门 $Z_o$:决定哪些将会被当成当前状态的输出。

细胞状态:在LSTM中负责存储和传递信息,以便于捕获长期依赖关系。

2.2 LSTM的工作流程

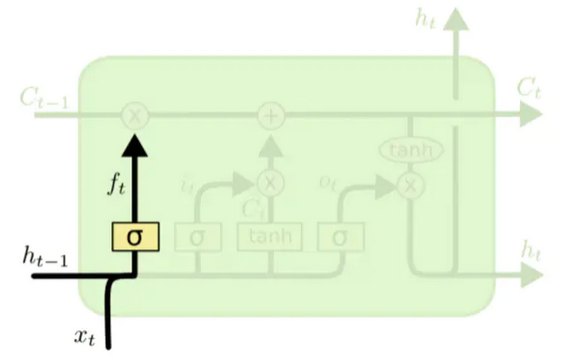

1.遗忘门的输出($f_t$):

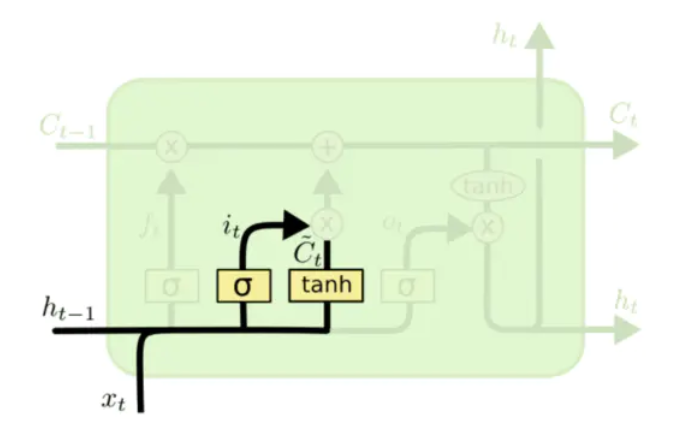

2.候选细胞状态($\tilde{C}$)及输入门($i_t$)

3.更新状态值($C_t$)

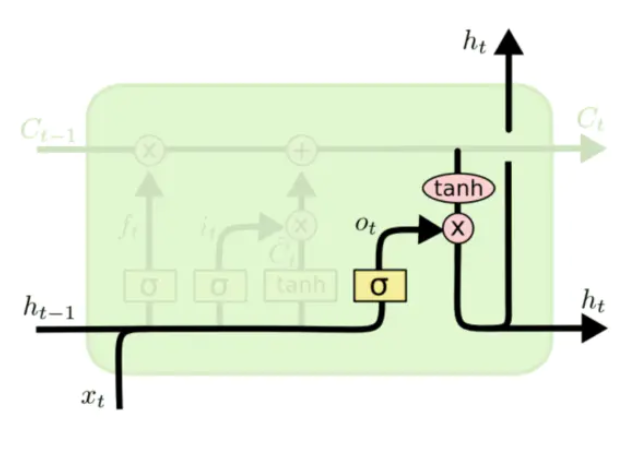

4.输出

注:

*利用tanh来映射细胞状态信息的原因:tanh函数其输出在-1-1之间,这与大多数场景下特征分布是0中心的吻合。tanh函数在输入为0附近相比 Sigmoid函数有更大的梯度,通常使模型收敛更快。*

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 丹青两幻!

评论